urllib.parse模块

该模块可以完成对url的编解码。

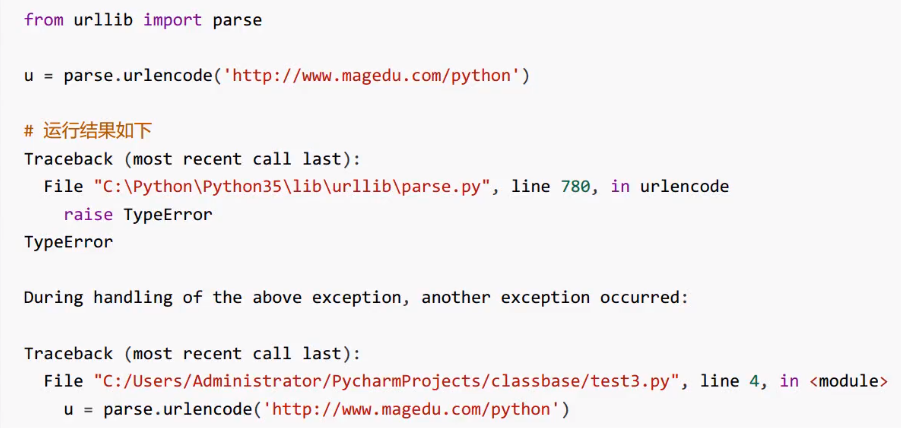

先看一段代码,进行编码。

此时查看结果,程序显示TypeError错误,urlencode函数第一参数要求是一个字典或者二元组序列。

我们修改代码:

from urllib import parse

d = {

'id':1

'name': 'tom'

}

url = 'http://www.magedu.com/python'

u = parse.urlencode(d)

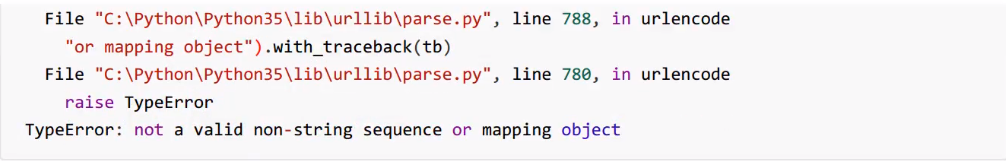

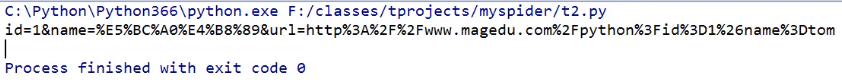

print(u)执行结果:

我们将结果拼接:

url = 'http://www.magedu.com/python?id=1&name=tom'此时,类似于查询字符串,相当于get方法

若再次修改:

url = 'http://www.magedu.com/python'

body 'id=1&name=tom'则此时相当于post请求。

from urllib import parse

d = {

'id':1

'name': 'tom'

'url': 'http://www.magedu.com/python?id=1&name=tom'

}

u = parse.urlencode(d)

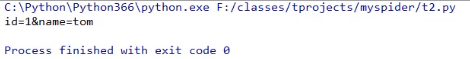

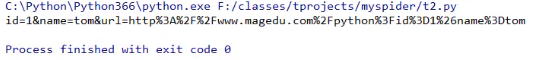

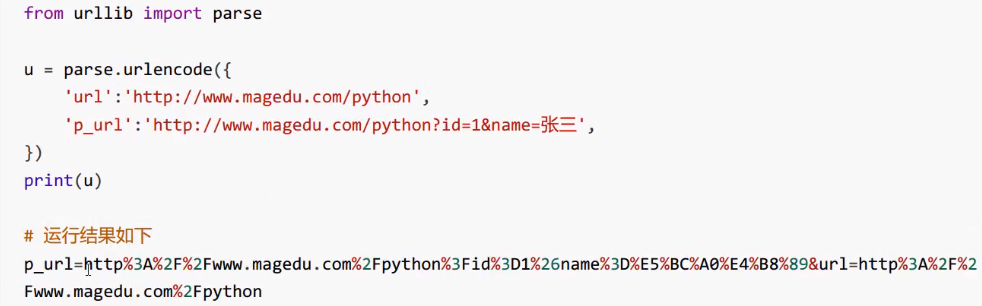

print(u)执行结果:

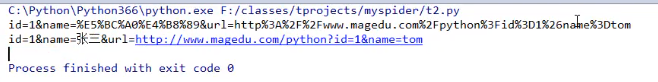

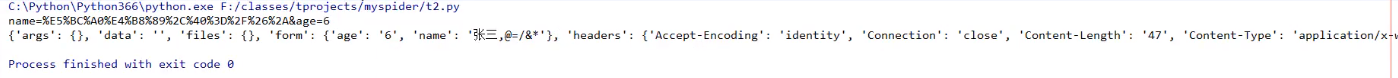

我们修改name为“张三”:

'name': '张三'执行结果:

从运行结果来看冒号、斜杠、&、等号、问号等符号全部被编码了,%之后实际上是单字节十六进制表示的值。

一般来说url中的地址部分, 一般不需要使用中文路径, 但是参数部分, 不管GET还是POST方法, 提交的数据中,可能有斜杆、等号、问号等符号,这样这些字符表示数据,不表示元字符。如果直接发给服务器端,就会导致接收方无法判断谁是元字符, 谁是数据了。为了安全, 一般会将数据部分的字符做url编码, 这样就不会有歧义了。后来可以传送中文, 同样会做编码, 一般先按照字符集的encoding要求转换成字节序列, 每一个字节对应的十六进制字符串前加上百分号即可。

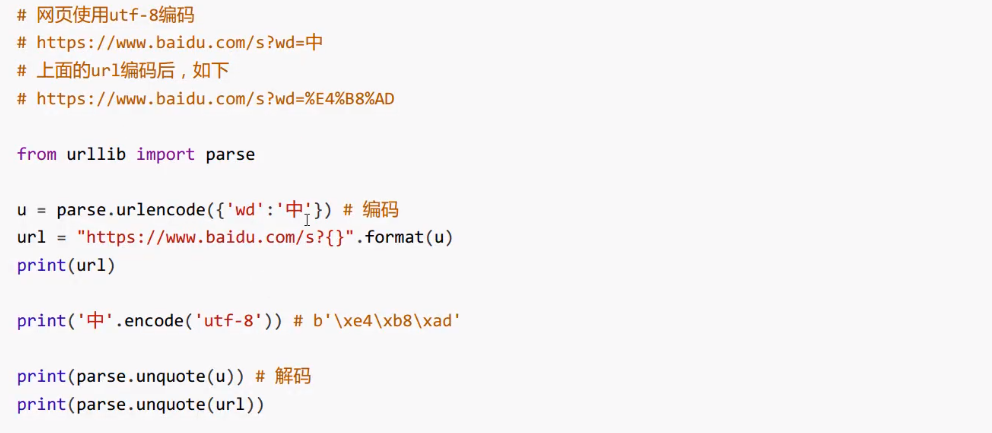

网页使用utf-8编码:

之前都是进行编码过程,现在来看一下解码的过程:

from urllib import parse

d = {

'id':1

'name': 'tom'

'url': 'http://www.magedu.com/python?id=1&name=tom'

}

u = parse.urlencode(d)

print(u)

x = parse.unquote(u)

print(x)执行结果:

以上就是对parse模块的介绍,其余的我们不再进行演示了,下面来了解method方法。

提交方法method

最常用的HTTP交互数据的方法是GET、POST。

GET方法, 数据是通过URL传递的, 也就是说数据是在HTTP报文的header部分。POST方法, 数据是放在HTTP报文的body部分提交的。

数据都是键值对形式, 多个参数之间使用&符号连接。例如a=1&b=abc

GET方法

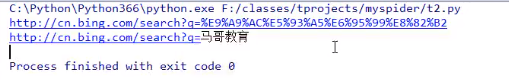

连接 必应 搜索引擎官网,获取一个搜索的URLhttp://cn.bing.com/search?q=马哥教育

需求

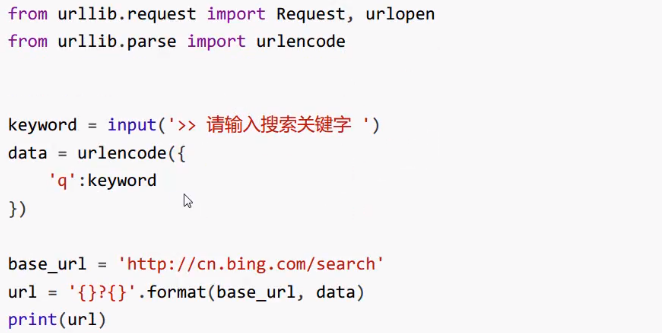

请写程序完成对关键字的bing搜索, 将返回的结果保存到一个网页文件。

from urllib import parse

base_url = 'http://cn.bing.com/search'

d = {

'q':'马哥教育'

}

u = parse.urlencode(d)

url = '{}?{}'.format(base_url, u)

print(url)

print(parse.unquote(url))执行结果:

此时不能发出请求。我们添加代码:

from urllib.request import urlopen, Request

ua = "Mozilla/5.0 (Windows NT 6.1) AppleWebKit/537.36 (KHTML, like Gecko) Chrome/55.0.2883.75 Safari/537.36"

req = Request(url, headers={

'User-agent':ua

})

with urlopen(req) as res:

with open('o:/bing.html', 'wb+') as f:

f.write(res.read())

f.flush()程序执行成功。这是对特定页面的爬取。

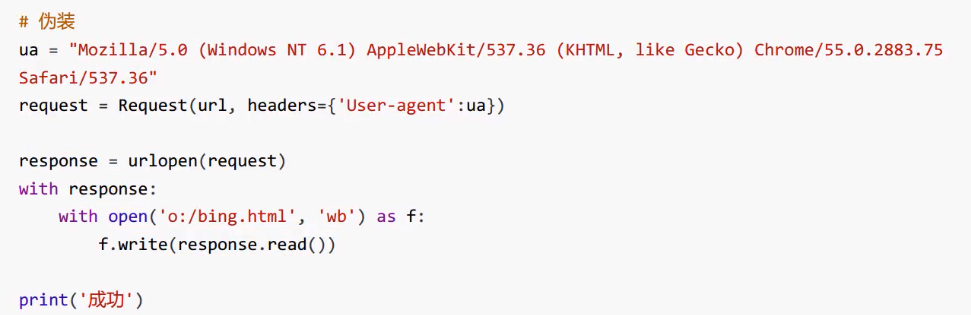

POST方法

http://httpbin.org/ 测试网站

我们来测试一下:

from urllib import parse

from urllib.request import urlopen, Request

import simplejson

url = 'http://httpbin.org/post' # POST

data = parse.urlencode({'name':'张三,@=/&*', 'age':'6' }) # body

ua = "Mozilla/5.0 (Windows NT 6.1) AppleWebKit/537.36 (KHTML, like Gecko) Chrome/55.0.2883.75 Safari/537.36"

req = Request(url, headers={

'User-agent':ua

})

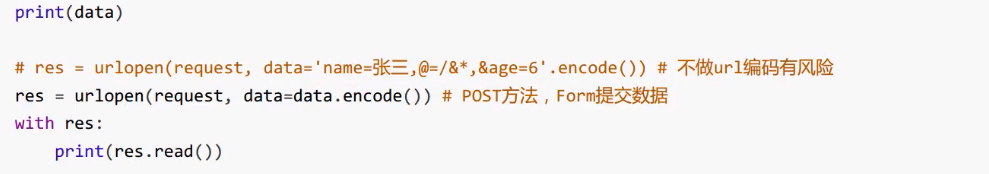

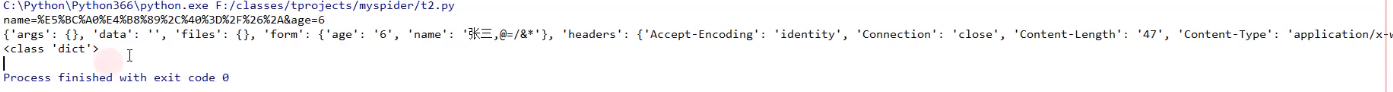

print(data)

with urlopen(req, data=data.encode()) as res: # POST请求,data不能为None

text = res.read()执行结果:

打印一下d的类型

print(type(d))执行结果:

通过这种方式就实现了post交互,我们将data提交上去,就是发送post请求,如果对方的网站有响应,会返回数据,返回的数据是正好是json,所以对其用simplejson进行转换。我们是需要根据网站返回的结果,去选择合适的方法处理转换数据。

配套视频课程,点击这里查看

获取更多资源请订阅Python学习站